Snips a développé une méthode pour "entraîner" les algorithmes d'intelligence artificielle sans aucune donnée réelle. Son PDG, Rand Hindi, nous explique comment son idée va révolutionner l’interface vocale.

D’où vient l’idée de Snips ?

Notre ambition avec Snips est de rendre la technologie accessible à tous en facilitant la communication entre l’homme et la machine. Aujourd’hui, nous sommes submergés d’appareils en tous genres, dont il faut apprendre à se servir. Lorsque vous avez une trentaine d’appareils avec chacun un mode d’emploi différent, ça devient vite un casse-tête. Maintenant, si ces objets sont capables de dialoguer avec vous en langage naturel, leur utilisation devient naturelle et facile. Notre solution propose ainsi à n’importe quel fabricant d’intégrer la voix à son appareil.

Vous lancez aujourd’hui un service de "Data Generation", une idée selon vous «révolutionnaire». En quoi cela consiste ?

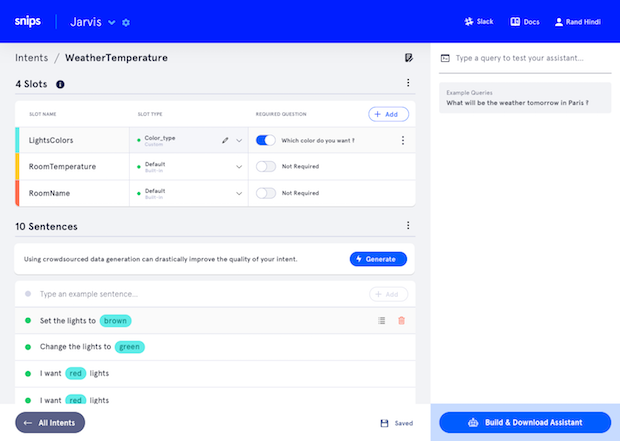

Notre solution de Data Generation génère des milliers de «fausses données» afin d’entraîner les assistants vocaux. Un peu comme pour la reconnaissance de photos, un assistant vocal a besoin de milliers d’exemples de requêtes pour y apporter des réponses adaptées. Plus il a d’exemples, et plus il sera efficace.

Aujourd’hui, lorsqu’un fabricant lance un appareil, il demande a ses développeurs d’imaginer eux-mêmes une trentaine d’exemples pour nourrir l’algorithme, puis récupère au fur et à mesure les données des utilisateurs. Ça pose deux problèmes : d’abord, les développeurs n'ont pas une imagination illimitée. L’assistant vocal risque donc d’être peu performant au départ. Ensuite, récupérer les requêtes des utilisateurs soulève des questions de vie privée, car certains ne veulent pas partager leurs données.

Grâce à un savant mélange entre un apport humain et un traitement algorithmique, notre service de Data Generation fabrique des milliers de requêtes virtuelles. On obtient l’équivalant de six mois de données d’utilisation avant même le lancement du produit !

Vous voulez donc concurrencer Google ou Amazon Alexa ?

Tout à fait. Grâce à leurs millions d’utilisateurs à travers le monde, les GAFA disposent d’une base de données immense. Notre solution permet à n’importe qui d’en générer autant et d’être sur un pied d’égalité. Mais surtout, la plupart des données des GAFA ne sont finalement pas très utiles pour le futur. Car les exemples de requêtes dont on a besoin… n’existent pas encore. Personne n’a encore vraiment utilisé de télévision connectée ou de frigo intelligent. L’autre avantage de notre technologie, c’est que les données sont entièrement traitées dans l’objet lui-même et non dans un cloud. Nous sommes ainsi les seuls à répondre à la future réglementation européenne sur la vie privée, le RGPD.

Snips s’adresse donc à tout le monde ?

Exactement. Nos solutions sont en accès libre sur notre site et utilisables gratuitement par n’importe quel développeur. Nous avons même un père de famille qui a créé un jeu de mots vocal pour ses enfants ! Depuis le lancement de notre plateforme en juin, plus de 13 000 assistants vocaux ont été créés, de la cafetière connectée au futur site e-commerce de chaussures. Ça permet de tester son idée grandeur nature. Pour une utilisation commerciale, nous vendons la technologie en «marque blanche» aux grandes entreprises et aux professionnels. Ils disposent ainsi de leur propre «Alexa» maison ! Une trentaine d’entreprises sont actuellement en test.

C’est un énorme marché ?

Ça dépasse même nos espérances ! Plus de 300 entreprises sont déjà venues vers nous, et ce sans aucune campagne de communication ou marketing. On prévoit deux à trois milliards d’objets connectés dans le monde d’ici 2021. Des objets qui devront forcément être équipés d’une interface vocale. Notre seule limite, c’est l’argent. Nous avons levé 12 millions d’euros en juin, mais lancer une nouvelle langue, par exemple, coûte très cher. On a déjà intégré le français, l’anglais, l’allemand, l’espagnol et le coréen, et bien entendu, on travaille déjà des algorithmes encore plus intelligents pour demain.